Durante l'AI Summit 2019, Intel ha dato il benvenuto alla prossima ondata di intelligenza artificiale (AI), annunciando aggiornamenti riguardanti Intel Nervana e Intel Movidius Myriad, progettati per accelerare lo sviluppo e l'implementazione dei sistemi di AI dal cloud fino all’edge.

Durante l'AI Summit 2019, Intel ha dato il benvenuto alla prossima ondata di intelligenza artificiale (AI), annunciando aggiornamenti riguardanti Intel Nervana e Intel Movidius Myriad, progettati per accelerare lo sviluppo e l'implementazione dei sistemi di AI dal cloud fino all’edge.

L’azienda ha dato una dimostrazione dei suoi processori di rete neurale (Neural Network Processors, NNP) Intel Nervana per l’addestramento (NNP-T1000) e l’inferenza (NNP-I1000): sono i primi ASIC di Intel sviluppati appositamente per il deep learning complesso, con livelli incredibili di scalabilità ed efficienza per i clienti che operano nei settori cloud e data center. Intel ha rivelato, inoltre, la prossima generazione di unità di elaborazione visiva (Vision Processoing Unit, VPU) Intel Movidius Myriad per applicazioni multimediali, di visione artificiale (computer vision) e inferenza in edge.

Questi prodotti rafforzano ulteriormente il portafoglio di soluzioni di intelligenza artificiale di Intel, che – secondo le previsioni – dovrebbe generare oltre 3,5 miliardi di dollari di fatturato nel 2019. Il portafoglio di soluzioni AI di Intel, il più grande nel settore per ampiezza e profondità, aiuta i clienti a favorire lo sviluppo e l'implementazione di modelli di intelligenza artificiale su qualsiasi scala, dagli enormi cloud ai minuscoli dispositivi edge.

I nuovi processori di rete neurale Intel Nervana NNP, già in produzione e consegnati ai clienti, fanno parte di un approccio all’AI a livello di sistema che offre un software completo sviluppato con componenti open e integrazione di framework per il deep learning, per essere utilizzati al massimo.

Intel Nervana NNP-T raggiunge il giusto equilibrio tra computing, comunicazione e memoria, consentendo scalabilità quasi lineare ed efficienza energetica dai piccoli cluster fino ai più grandi supercomputer per POD (Performance Optimized Datacenter). Intel Nervana NNP-I è efficiente in termini di consumi e budget ed è ideale per eseguire inferenze multimodali intensive su scala reale utilizzando fattori di forma flessibili. Entrambi i prodotti sono stati sviluppati per le esigenze di elaborazione di intelligenza artificiale da parte di clienti all'avanguardia, come Baidu e Facebook.

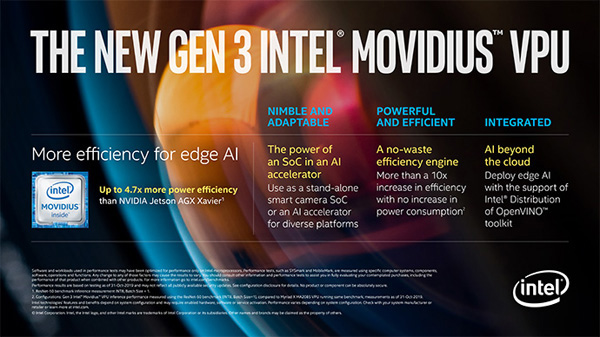

Inoltre, la prossima generazione di unità di elaborazione visiva Intel Movidius, prevista per la prima metà del 2020, includerà avanzamenti architetturali esclusivi estremamente efficienti, volti ad offrire prestazioni oltre 10 volte superiori alle prestazioni di inferenza della generazione precedente, con efficienza energetica fino a 6 volte superiore rispetto ai processori della concorrenza. Intel ha anche annunciato il nuovo Intel DevCloud for the Edge, che, insieme alla distribuzione Intel del toolkit OpenVINO, risolve un aspetto cruciale per gli sviluppatori, consentendo loro di sperimentare, prototipare e testare soluzioni di intelligenza artificiale su un'ampia gamma di processori Intel prima di acquistare hardware.

Sono necessari dati, modelli e tecniche incredibilmente complessi affinché il deep learning progredisca, e questo richiede di pensare diversamente alle architetture.

Con la maggior parte del mondo che esegue parte delle proprie operazioni di intelligenza artificiale con processori Intel Xeon Scalable, Intel continua a migliorare questa piattaforma con funzionalità come Intel Deep Learning Boost con Vector Neural Network Instruction (VNNI), che offre prestazioni di inferenza AI migliorati ad ogni livello di implementazione, dai data center alla periferia della rete. Mentre questa piattaforma continuerà ad offrire robuste fondamenta per l’intelligenza artificiale per molti anni, le esigenze più avanzate di addestramento del deep learning da parte dei clienti di Intel richiedono che le prestazioni raddoppino ogni 3 mesi e mezzo, e questo tipo di innovazione può avvenire soltanto con un portafoglio di soluzioni di intelligenza artificiale come quelle di Intel.